Данная заметка является продолжением этой и этой заметок.

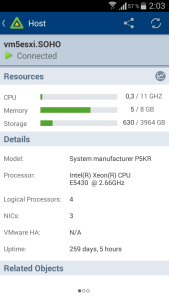

С момента их написания прошло уже достаточно много времени и можно сделать некоторые выводы. В общем, все выводы умещаются в одной единственной картинке:

Т.е. аптайм машины составляет внушительные 8 с хвостиком месяцев. Надо отметить что выключение 260 дней назад было плановым — для установки обновлений на хост и подключения SSD для кэша чтения.

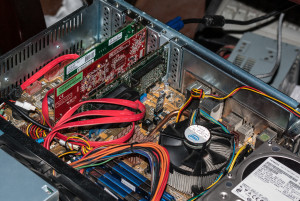

Так же хочу поделится фотографией общего вида системы, сделанной больше года назад:

На картинке можно разглядеть следующие компоненты:

- Боксовый кулер (под ним Xeon E5430)

- Контроллер HP SmartArray P400, о котором я писал отдельно и неоднократно

- Видеокарта ATI ES1000 (32MB, PCI, DVI)

- Сетевая карта Intel

PRO/1000PT DualPort - USB DOM 8GB под ESXi

- Один из трёх дисков HITACHI 2 TB

- Память Kingston HyperX 4x2GB DDR2-800 CL4

- Корпус NONAME 2U

В целом, особенно после установки SSD Crucial M4 256GB в качестве кэша чтения, производительность данной платформы меня более чем устраивает для домашних и тестовых нужд. Система в меру отзывчива и гибка в конфигурировании. Немного не хватает скорости для снапшотов (в «старом» гипервизоре на P5Q-Premium было два быстрых датастора) и VT-d, но без этого пока можно пережить.

В общем, считаю свой опыт удачным и думаю поработать на этом железе еще годик, на ESXi 5.5, а дальше переходить на что-то новое. На самом деле на аптайм я обратил внимание случайно, воспользовавшись мобильным клиентом VMWare. Конечно, я примерно представлял каков он, но точные цифры на глаза не попадались.

Косвенно, данный опыт может служить еще одной иллюстрацией целесообразности этой практики и иллюстрацией стабильности подобных систем даже в более жестких, чем бытовые, условиях.

Вот у меня есть ASUS P5K и я планирую поставить на не нее Xeon.

Так вот вопросик такой, если P5K и P5KR отличаются между собой только южным мостом то смогу ли я поставить 4×4 GB, тоесть 16GB RAM но только китайских кингстонов которые идут только под AMD по убеждениям продавцов. Или тут нужно только expensive RAM?

«Китайские» на 32 чипах BGA на интеле не работают 🙁 Проверял.

Данный комментарий был бы более логичен тут — http://ideafix.name/?p=2461

Епты, а я ведь туда хотел написать, запутался в открытых вкладках(

Кстати, эти модули и на АМД не очень работают. Плата модуля даже визуально тоньше (сама полоска текстолита) и в слотах, в которых до этого много лет стояла нормальная память, эти модули работают плохо. Чуть задел — синька 🙁

Здравствуйте.

Очень понравилась ваша статья, так как в наличии имеется похожее аппаратное обеспечение.

Материнская плата Asus, raid controller Smart Array P400 и SSD team group. Хотелось бы получить из этого набора наиболее производительную систему. Все в общем понятно, кроме «подключения SSD для кэша чтения». Это имеется в виду технология «VMware Virtual Flash» точнее » VMware Flash Read Cache (vFRC)»? Но на сколько я понял включить данную функцию можно только из VMware vSphere Web Client?

С уважением, Петр.

На самом деле, всё немного не так. У вмвари есть следующее:

1. СВОП гипервизора.

2. СВОП виртуальных машин.

3. Дисковый кеш на виртуальном флеш.

Первое и второе доступно начиная с 5.5 кажется и отрабатывает когда в первом случае есть дефицит оперативной памяти, а во втором, когда есть большой объём вытесняемой памяти у машин (из корбки на датасторе создаётся swp файл равный объёму памяти на случай вытеснения). Третье по факту настраивается только в вцентре, /ui не умеет этого. Но в принципе, наверное можно всё сделать через cli и правку vmx файлов.

Особо много от данной связки Вы не получите, имею в виду 775+P400.

Благодарю за столь быстрый ответ.

На самом деле плату Asus на 775 сокете мы хотели использовать для тестов.

У нас в планах есть идея поднять свой веб-сервер и сервер bigbluebutton на одном физическом сервере. Для виртуализации хотели использовать esxi 5.5 или более поздную. Самого сервера пока нет, но по нашим средствам нам предлагают б.у. сервер Dell R610 с одним из RAID контролеров (PERC 6i или H200 или H700). В наличии есть только сервер HP Proliant 360 G5 (два xeon процессора с частотой 3ГГц и 4 ядрами каждый, 26 ГБайт памяти и двумя raid контролерами smart array p400 к каждому подключено по 8 шт 76Гб sas дисков.)

Так как сервер планируем поддерживать сами, то хотели максимально упростить настройку за счет использования следующей связки программных продуктов:

Шлюзом (за которым будет размещаться веб сервер и другие вспомогательные виртуальные машины) сделать на kerio control 9.1.2 (он уже давно работает в esxi 5.5 и достаточно не плохо себя показал).

Веб-сервер планируем поднять на базе ispconfig панели на ubuntu 16.04. Сама ОС установлена на один виртуальный диск, а база данных и папка с данными и с самими сайтами вынесена на другой виртуальный диск.

Виртуальный synology nas. Резервные копии веб-сервера планируется делать с помощью veeam backup for linux (логический диск с ОС) и rsync (данные сайтов). И rsync и veeam backup должны будут создавать резервные копии на данный виртуальный synology nas.

Т.е. за шлюзом у нас будет минимум 2 виртуальные машины (bigbluebutton будет со снаружи шлюза):

Сам веб-сервер

Виртуальный synology nas.

Вопрос заключается в следующем: Как оптимально настроить и производительность и надежность данной системы?

Предполагалась следующая конфигурация:

Сам ESXi разместить либо на флэшке, либо на одном из sas raid 1 дисков.

Сами виртуальные машины и файлы их виртуальных дисков с ОС разместить на одном из sas raid 1 дисков. Общий их размер не превысит 60 Гб.

Виртуальный диск на котором будут храниться база данных mysql и сами сайты разместить на ssd диске (или на raid 1 из ssd дисков) для максимальной скорости доступа.

В виртуальный synology nas пробросить два жестких большого объема которые средствами самого synology nas объединить в программный раид.

Что нам это дает?

SAS RAID 1 дает надежность (загрузка самого esxi, работа виртуальных машин).

SSD RAID 1 дает скорость (база данных и сайты).

SATA soft RAID 1 (резервные копии) дает много места и возможность восстановить одну из нескольких резервных копий всего сервера подключив один из дисков этого raid к любому компьютеру с ОС linux.

Так как это по большей части теория, хотелось бы узнать Ваше мнение по поводу такой конструкции?

С уважением, Петр.

Покликал по ссылкам и вижу что мы немного земляки… мен Рудный каласында турамын 🙂 Ну а теперь по делу…

1. veeam бывает бесплатный в том числе для коммерции, esxi бывает бесплатный, в том числе для коммерции, но бесплатный veeam не работает с бесплатным esxi. В России реализации иного мнения подпадают под определение статьи 146 Уголовного кодекса. Я не отговариваюи не пугаю, просто мыслю вслух.

2. ESXi 5.5 не поддерживается уже года полтора. Не страшно? ESXi 6 взлетит и на пролианте G5 и на Dell, имеет старый толстый клиент и еще будет поддерживаться какое-то время. Может посмотреть в эту сторону?

3. Виртуальный синолоджи — это ведь сломанная синолоджи ОС? То же самое что и в п.1. Оно надо на продакшене? Есть же куча альтернатив, или просто привыкли к этому и не соскочить?

По нагрузочной способности сервера мне тяжело говорить не понимая нагрузки. Что именно это будет за LAMP? Что он будет обслуживать? Какой сервис, сколько посетителей? На самом деле догма «база на ssd» вообще не догма, и если, к примеру, купить 128GB памяти, то может получиться куда интереснее, чем SSD. У меня есть высоконагруженный сервис на LAMP, плоский дамп базы которого весит 16GB. При этом, характер работы — генерация динамики. Поиск работает рядом на SOLR. Вот SOLR да, теребит диск постоянно, а MUSQL закешировал чего-то в памяти на 20GB и на диск вообще не ходит. Если не говорить об электронной коммерции, то в моей практике с LAMP в плане работы на любом оборудовании всегда удавалось договориться, а вот JAVA/SOLR — это да. Сколько не дай — мало.

На сколько я понимаю, хост будет один, вмварь будет относительно старая и об nvme raid карте речи не идёт, зато никаких HCL и самосбор только в путь! При таком раскладе можно взять такой HWRAID, который был бы в HCL вмвари в плане зеркал и таки сделать зеркало из SATA/SAS SSD и возможно длинный рейд под облако. С NVME было бы интереснее, но как это всё зеркалировать… не зная поколения 610-го, трудно о чем-то говорить, равно как и не зная нагрузок трудно о чем-то говорить, но всё же, вы просчитывали нагрузку, прикидывали треды/память/сеть?

Но если без учета всех неизвестных оценивать, то…

1. Идея с кучей зеркал в 1U корпусе мне скорее нравится.

2. Идея с экономией на спичках (мелкие SAS диски) не нравится. В принципе, новый серверный NVME SSD хоть в M2 хоть в U2 БЕЗ ГАРАНТИЙ можно купить в пределах $100 за 1TB и дешевле. Если рассмотреть SSDдатастор без зеркала — вполне себе вариант.

3. Идея с SWRAID скорее не понятна. Как именно будете отдавать диски (контроллер?) в гостевую ОС? Вмварь не умеет тупо отдавать блочные устройства в виртуалку. Будете вколачивать mdadm в esxi?

4. Не знаю точно как у Dell, но HP всегда имеет внутренний USB разъём и очень часто имеет внутренний полноразмерный SD разъём как раз для гипервизора. Флешку только попорядочнее, и логи не в неё писать, а на датастор.

5. Идея с 1U… даже не знаю, но учитывая сколько стоит на вторичном рынке PowerValut1200, может не такая уж и плохая идея.

Очень приятно что не перевелись и на нашей земле специалисты. Мен Алматыда тұрамын.

1.По поводу veeam backup agent for linux. Если не ошибаюсь у бесплатной версии ограничение создание только одного задания (а не нескольких) и какие-то ентерпрайз функции.

2.На версию 6 планировали перейти, только вот неудачный опыт установки на старое железо как-то прервал попытки ей воспользоваться. Версия 5.5 у нас заработала и нам этого хватило.

3.Если не ошибаюсь то с лицензией на synology проблем быть не должно. https://xpenology.com/forum/topic/4448-лицензия-временная/. По поводу альтернатив данному продукту не знаю (не большой специалист в данной области).

Как раз про нагрузку я и забыл сказать. Основных задачи у сервера всего две. Это веб-сервер moodle (дистанционное форма обучения при алма-атинской семинарии) и сервер видеоконференций bigbluebutton. В moodle всего около 400 пользователей которые в среднем тратят на работу с сайтом около получаса в день, а то и меньше. Содержание сайта пока в основном текстовое и графическое. Ни видео, ни аудио почти нет (мы пока на простом хостинге, а там очень мало места). В будущем планируем конечно и видео и аудио размещать. Т.е. и трафик и загрузка процессора в данный момент по минимуму. Никаких мощных cron задач тоже нет. В основном это несложные плановые операции moodle. А вот работа с базой и файлами мне казалась очень большой нагрузкой для жесткого диска. Такое мое мнение основано на том, что когда я производил отладку некоторых самописных плагинов, то на жестком диске у меня отладка сильно дергала диск и шла достаточно медлено. После перехода на ssd отладка пошла намного быстрее. Возможно проблема в том, что для отладки я полностью отключил кэширование, так как файлы с кодом должны были подтягиваться каждый раз именно с диска. База данных у нас около 7 Гигабайт. Файлы данных около 15 Гигабайт. Файлы с кодом всего около 300 Мегабайт, но их около 64000.

Второй сервер, видеоконференций он как раз представляет из себя сбор множества разных open source проектов, в том числе если не ошибаюсь и java и nodejs и другие. Он как раз очень прожорлив в отношении памяти. Но так как у нас видеоконференции проходят не очень часто и в них не очень много пользователей одновременно принимают участия, то для него достаточно 4 ядра по 2 Гигагерца и 4 Гигабайт памяти. Жесткий диск почти не используется (мы не ведем записи видеоконференций). Сетевая нагрузка даже с включенным видео у каждого пользователя не больше 1 мегабит. Максимальное число одновременных пользователей человек 20.

Итого:

1. RAID зеркала оставляем.

2. SAS hdd мы можем поискать и побольше. Уже сейчас нам предлагают б.у. 300 ГБайтные не очень дорого. Или лучше новые? Или большего размера? С NVMe SSD мы ни разу не сталкивались, но судя по документации им нужен для полной скорости PCIe v3, а в dell r610 PCIe v2 (если не ошибаюсь).

3. Про “проброс” жестких дисков в виртуальную машину я нашел статью https://bobbyromeo.com/virtualization/raw-device-mapping-of-sata-storage-with-esxi-unraid/

И

https://www.experts-exchange.com/articles/9174/HOW-TO-Add-Local-Storage-e-g-a-SATA-disk-as-a-Raw-Disk-Mapping-RDM-or-Mapped-RAW-LUN-to-a-virtual-machine-hosted-on-ESXi.html

С их помощью и получилось пробросить hdd в виртуалку. После этого подключал эти диски к простому ubuntu и данные благополучно считывались.

4.Флэшку попорядочней постараемся найти и логи вести на датастор.

И по традиции можно задать в конце два вопроса?

Допустим у нас хватает оперативной памяти. Как настроить mysql для хранения базы в оперативной памяти?

Какие бы вы порекомендовали “надежные” желательно бюджетные ssd типа sas или sata для сервера?

С уважением, Петр.

1.Т.е. Вы бекапите ОС, а не VM? А чего не сшапшоты? Ну да это дело вкуса. если бекапить именно виртуальную машину, то бесплатный veeam и бесплатный esxi не дружат.

2. Всё же, посмотрите на кастомизированные образа того же HP. Оно совместимо с G5. У HP вообще деление на «старше G8» и «младше G8» и связано скорее с EFI/UEFI, ну и в 6.7 не поддерживаются уж совсем старые процессоры (lga1156|1366), а в остальном всё должно быть нормально.

3. По xpenology в общем всё, как я и думал — это варез. И в принципе, если нужен будет повод — это могут использовать как повод. В РФ прокуратура может начать защищать права правообладателя без заявления оного и даже при отказе правообладателя от претензий. Не знаю как оно у вас, но альтернатив, начиная от облаков (owncloud/hnextcloud) до именно NAS систем (OMV, xigmanas) куча.

По нагрузке…. линукс — он хороший:

Всю не занятую память сам использует как кеш чтения диска. На скриншоте это видно по желтой части загрузки памяти. Т.е. free -m покажет что свободной памяти 0, а вот cache/bufer — это по сути свободная память, в которой закешировано то, что читалось. На данном сервере только Apache+PHP, база отдельно. Общий объём контента не превышает 2-3GB, через 4-6 часов работы сервера оно всё в кеше. Диск не трогается практически.

С настройкой MySQL в принципе в гугл, там ничего сложного, но строить нужно с оглядкой на память и нагрузку, универсального решения нет.

По Moodle, на мой взгляд, вы скорее упретесь в сеть, нежели в диск. Вот эта https://elearn.urfu.ru/ штучка сидит в 16GB памяти а видео… блин, что-то мы тоже на JAVA R5/R7 прикручивали, уж не помню.

Идея с пробросом дисков в виртуалки так, как по Вашим ссылкам не нравится… обновлять такую штуку в случае чего — то еще удовольствие, а отвалится от неё всё при первом же обновлении первого же VIBа 🙁 В принципе, проблему можно было бы решить (и нужно) просто бекапом в другую коробку, т.е. чтобы бекапы не на этом же сервере хранились, но тут понятно что человек лишь предполагает… и не всё от нас зависит.

По дискам — если совсем по жесткому, то https://www.ebay.com/itm/Sandisk-Skyhawk-NVMe-PCIe-SSD-1-92TB-2-5in-PCIe-Ultra-NVMe-SSD/143510955617 посмотрите… это те самые интерпрайзные 2ТБ дешевле 200 баксов даже с учетом доставки (в РФ). А у этого товарища и 4ТБ модельки есть и SAS диски и др. и пр. Если же смотреть на магазин и на новое с гарантией, то я бы наверное указал на Micron 5100/5200.

У меня у самого, сейчас уточнил, стоит Intel 750 1.2TB U2. Это потребительский (для энтузиастов) SSD на MLC памяти. Работает очень хорошо, упирается в PCI-E 2.0 по скорости, но работает без проблем. С большой пачкой (2-4 штуки) U2 дисков могут быть проблемы с установкой (https://aliexpress.ru/item/4000547552568.html не смотрите на картинку, это 4х плата) и по физике и по питанию (оно правда ждет от 25 до 75W в зависимости от модели), но если подготовиться на берегу, то проблем не будет.

Мне как-то боязно советовать Fusion-IO, WarpDrive и даже новые HGST U2 NVME диски т.к. в случае чего вы простос пишете их с баланса. Ни один дата рикавер за них не возьмётся и официальной гарантии нет на них. Микрон 5100/5200 и Интел 45×0/46×0 будут сильно (втрое?) дороже и при этом TLC, но… одно дело моя домашняя лаба, за которую я отвечаю сам, и другое — продакшенный сервис.

Немного о корпоративном интеле: Intel RMA service — опыт обмена SSD.

Немного о Fusion-IO: https://forum.ixbt.com/topic.cgi?id=11:48723 вот эти карточки меня реально зацепили, но учитывая цену на allflash датастор говорить о vfrc наверное уже нет смысла.

Может в почту? ideafix@ideafix.name